Da vacinação aos dados empresariais: como blockchains estão se tornando aliadas da segurança digital

Por Diogo de Oliveira, Roger Bezerra Candido e Andressa Diovana Dalcastagnê

A tecnologia por trás das criptomoedas vem ganhando espaço em áreas muito além do setor financeiro. Sistemas baseados em blockchain já são usados para proteger registros de vacinação, garantir autenticidade de documentos e evitar fraudes em ambientes digitais. Pesquisas brasileiras mostram como diferentes modelos da tecnologia podem tornar esses sistemas ainda mais seguros e eficientes.

Durante a pandemia da Covid-19, um detalhe tecnológico ganhou destaque em uma reportagem do G1 publicada em 4 de maio de 2023: o sistema digital que registrava as doses aplicadas não permitia que uma vacinação fosse apagada sem deixar rastro. Qualquer alteração gerava automaticamente um histórico que mostrava quem realizou a modificação, quando ela ocorreu e qual informação foi alterada. Essa camada de rastreabilidade, descrita na matéria, segue precisamente a lógica das blockchains: a garantia de que dados sensíveis não desaparecem e que qualquer tentativa de mudança deixa evidências verificáveis.

Como funciona uma blockchain

A ideia central por trás dessa tecnologia é simples: em vez de um único servidor responsável por armazenar tudo, os dados são distribuídos entre vários computadores, que precisam entrar em um consenso e concordar entre si antes que qualquer nova informação seja registrada. Isso cria um sistema em que adulterações silenciosas praticamente não são possíveis. Mesmo instituições que não adotam blockchains completas passaram, nos últimos anos, a incorporar mecanismos inspirados nesse modelo, especialmente quando lidam com informações sensíveis ou processos que exigem transparência e confiabilidade.

Além das aplicações públicas, empresas e órgãos governamentais têm apostado nas blockchains privadas, que funcionam como redes fechadas, com controle rigoroso sobre quem pode participar. Elas são usadas em sistemas de credenciais digitais, plataformas de autenticação, registros empresariais e monitoramento interno de dados. É nesse contexto que se insere a pesquisa realizada por Carlos Schmitt Bunn, estudante de Ciências da Computação da Universidade Estadual de Santa Catarina (UDESC), de Joinville. Ele analisou três mecanismos de consenso: IBFT 2.0, QBFT e smartBFT. Eles são usados para garantir a concordância entre os computadores de uma rede blockchain permissionada.

“A minha ideia foi verificar qual dos três protocolos é mais eficiente. O IBFT 2.0 e o QBFT utilizam uma arquitetura diferente do smartBFT, então, avaliar qual desses três tipos de arquitetura possui o melhor desempenho é importante para futuros pesquisadores já terem acesso às informações sobre o mínimo de funcionamento dessas redes, já que eles podem ver os resultados da minha pesquisa e não precisarão fazer uma pesquisa do zero para saber qual dos protocolos é o mais eficiente’, contou o acadêmico.

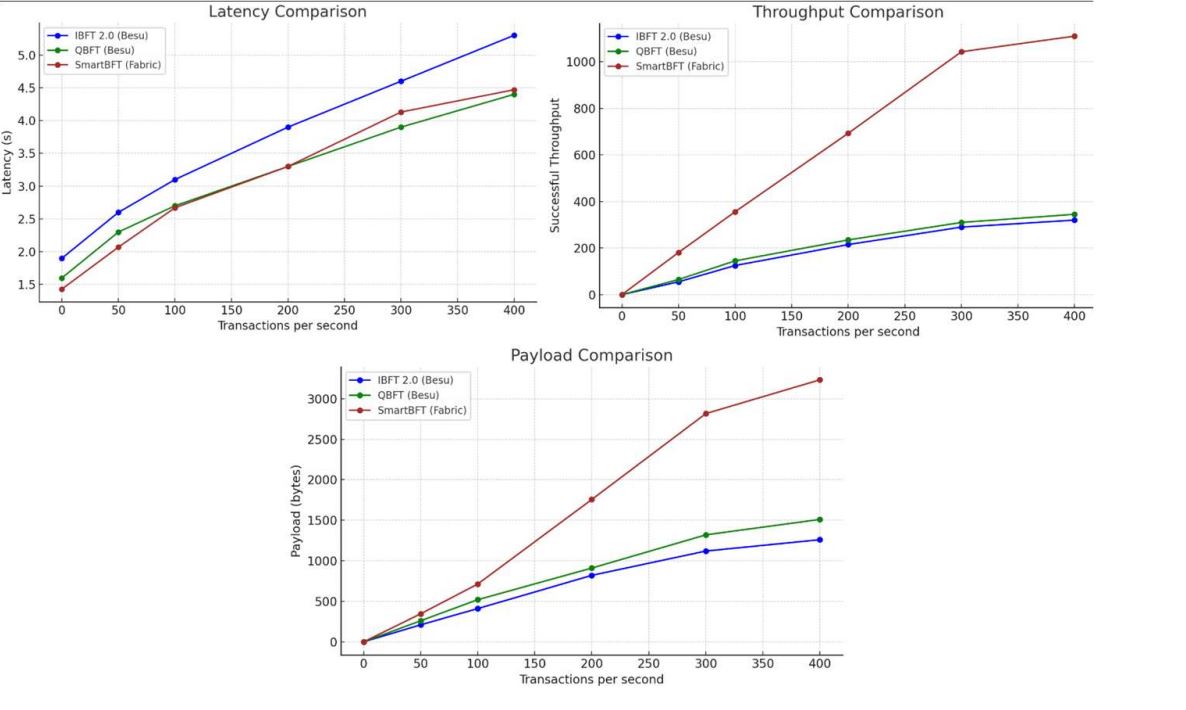

Bunn explica que a investigação desenvolvida no Laboratório de Processamento Paralelo e Distribuído (LabP2D) da UDESC, implementou redes blockchain com configurações semelhantes e as submeteu a diferentes cargas de transações para observar como se comportavam. O resultado mostrou que o protocolo smartBFT destacou-se como o mais eficiente, alcançando um melhor successful throughput e menor latência mesmo sob altas cargas, embora com payloads mais robustos devido a sua arquitetura modular. O QBFT ficou em posição intermediária, com boa estabilidade e escalabilidade, enquanto o IBFT 2.0, apesar de confiável, apresentou limitações em cenários mais intensos, sendo adequado a redes com menor volume de operações. Esses achados auxiliam na compreensão de quais tecnologias são mais eficientes e seguras para sistemas corporativos e governamentais que dependem de respostas rápidas e registro confiável.

Carlos Schmitt Bunn explica o que cada detalhe técnico significa. “A latência, que é onde o smartBFT se destaca dos outros consensos, é o tempo que uma mensagem demora para ir e voltar. Já o successful throughput representa o número de pacotes que foram enviados com sucesso, já que às vezes os pacotes se perdem no meio do caminho do cliente até o servidor. O payload é a quantidade de informação que está sendo passada a cada pacote”.

As diferenças entre esses mecanismos não são apenas detalhes técnicos: elas determinam a eficiência de sistemas que lidam com identidades digitais, armazenamento de documentos, serviços em nuvem e processos empresariais que exigem auditoria contínua. Ao estudar esses protocolos, a pesquisa contribui para o desenvolvimento de infraestruturas digitais mais seguras, capazes de resistir a ataques, adulterações e instabilidades, algo que é cada vez mais crucial diante do crescimento de ameaças cibernéticas, como ataques de hackers e vazamento de dados pessoais.

O orientador de Bunn na pesquisa foi o professor Charles Christian Miers, que é doutor em Engenharia Elétrica e mestre em Ciência da Computação com ênfase em Segurança/Criptografia. Miers explica porque a segurança da informação (ou cibersegurança) é uma ciência “base”. “Nela nós temos os pilares dessa área que chamamos de integridade, confidencialidade e disponibilidade. Com a criptografia, por exemplo, nós conseguimos manter principalmente a integridade e confidencialidade. Com isso, é possível garantir que as pessoas tenham seus dados protegidos”.

Sobre o laboratório de pesquisa

Como mencionado, a pesquisa de Bunn e Miers foi desenvolvida no Laboratório de Processamento Paralelo e Distribuído (LabP2D), da UDESC Joinville. Criado em julho de 2013, o laboratório oferece recursos humanos e materiais para realização de atividades de pesquisa, ensino e extensão. Os serviços oferecidos e pesquisas realizadas no ambiente tem como temas principais o gerenciamento de Nuvens Computacionais, Névoa Computacional, Internet das Coisas e Programação Paralela.

Atualmente, o LabP2D possui uma nuvem computacional privada, baseada em OpenStack, que hospeda diversos projetos de outros departamentos da instituição. Ainda, parcerias institucionais entre grupos de pesquisa brasileiros e franceses utilizam a nuvem para realização de experimentos. Hoje o laboratório hospeda um cluster de alto desempenho, duas nuvens computacionais, um cluster para atividades de ensino e outros equipamentos destinados à pesquisa. Veja alguns números do laboratório:

- Mais de 30 trabalhos de mestrado e doutorado concluídos.

- Mais de 60 trabalhos de iniciação científica e conclusão de curso concluídos.

- 2 editais com bolsas de produtividade em pesquisa do CNPq.

- Mais de 25 projetos com parcerias externas, com destaque para CNPq, Fapesc, ArcelorMittal, Fesc/Unimed, WEG, IBM, ENS Lyon.

- Mais de 4 mil horas de uso de recursos computacionais por mês.

Na última terça-feira, 8, o laboratório teve um evento de reinauguração, realizado no bloco F Centro de Ciências Tecnológicas (CCT). A cerimônia, realizada diante do novo painel instalado em frente ao laboratório, foi presidida pelo diretor-geral do CCT, Leandro Zvirtes, e contou ainda com a presença do diretor de Pesquisa e Pós-Graduação do CCT, André Bittencourt Leal, do chefe do Departamento de Ciência da Computação do CCT, Rui Jorge Tramontin Júnior, e dos três professores fundadores (ainda integrantes) do LabP2D: Guilherme Piêgas Koslovski, Maurício Aronne Pillon e Charles Christian Miers.

Atual coordenador do laboratório, o professor Guilherme fez uma apresentação sobre os 12 anos de atuação daquele ambiente que conjuga ensino, pesquisa e prestação de serviços relacionados à computação em nuvem para todo o CCT. Ele destacou a evolução da capacidade computacional do LabP2D, criado a partir da doação de computadores usados na Final Brasileira da Maratona de Programação, realizada em Joinville em 2010. Para se ter uma ideia, a estrutura atual do laboratório é classificada como versão 5.0 — e subindo, como disse Guilherme.

A iniciação científica como motor da inovação

Além de seus resultados técnicos, a pesquisa também evidencia a importância da iniciação científica na formação de novos profissionais. Como projeto financiado pelo CNPq, o trabalho permitiu que o estudante experimentasse, testasse, falhasse, comparasse e analisasse problemas reais de computação distribuída, adquirindo experiência que dificilmente seria obtida apenas em sala de aula. Esse tipo de formação prepara jovens pesquisadores para atuar em áreas estratégicas como segurança digital, que exigem atualização constante e domínio tecnológico refinado. Em um cenário de rápidas transformações, formar estudantes capazes de investigar, questionar e propor soluções é fundamental para fortalecer a produção científica e tecnológica do país.

Charles Christian Miers conta que a iniciação científica é uma forma de ir além do que é aprendido nas disciplinas que estão na grade obrigatória. Além disso, o professor também explica que isso ajuda no crescimento do aluno não só como profissional, mas também como pessoa. “Às vezes o resultado final não vai ser o que você esperava, mas isso não é algo negativo, isso te faz ter um outro olhar a aprender com isso, ajudando no crescimento da pessoa”.